2025, Digital Security, Technical News

Ordinateur quantique 6100 qubits ⮞ La percée historique 2025

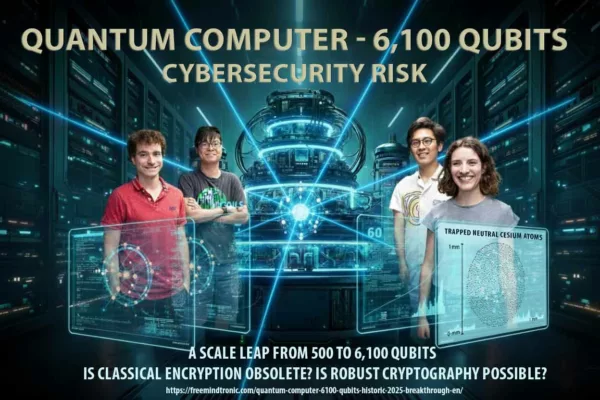

Ordinateur quantique 6100 qubits marque un tournant dans l’histoire de l’informatique, soulevant des défis sans précédent pour le chiffrement, la cybersécurité et la souveraineté numérique.

Résumé express — Ordinateur quantique 6100 qubits

⮞ Note de lecture

Ce résumé express se lit en ≈ 4 minutes. Il livre l’essentiel : découverte, impact immédiat, message stratégique et leviers souverains.

⚡ La découverte

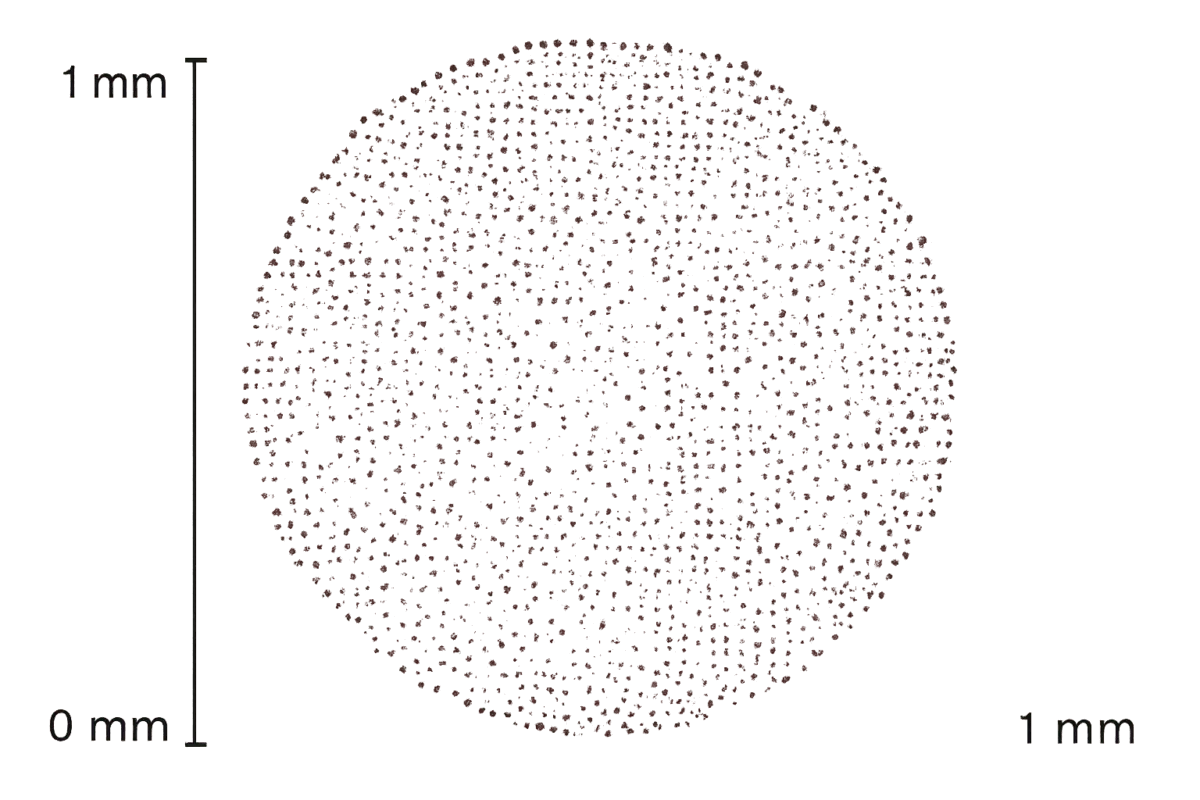

En septembre 2025, une équipe du Caltech publie un record mondial : une matrice de 6 100 qubits atomiques (atomes neutres en optical tweezers), documentée par un article dans Nature et détaillée par la note officielle du Caltech. Voir l’publication Nature et le communiqué Caltech. L’e-print arXiv précise notamment la cohérence (~12,6 s), la survie d’imagerie (99,98952 %) et la stratégie « zone-based » pour l’échelle utile. Ce chiffre dépasse largement les prototypes antérieurs (50 à 500 qubits) développés par IBM, Google, Microsoft, IonQ ou Atos.

✦ Impact immédiat

- Un saut d’échelle inédit qui bouscule les prévisions scientifiques.

- Une menace directe sur la robustesse du chiffrement asymétrique (RSA, ECC).

- Une accélération forcée de la transition vers la cryptographie post-quantique.

⚠ Message stratégique

Le passage à plusieurs milliers de qubits réduit drastiquement la fenêtre de résilience cryptographique. Si l’annonce se confirme, l’équilibre actuel de la cybersécurité mondiale est remis en question, bien avant les échéances prévues.

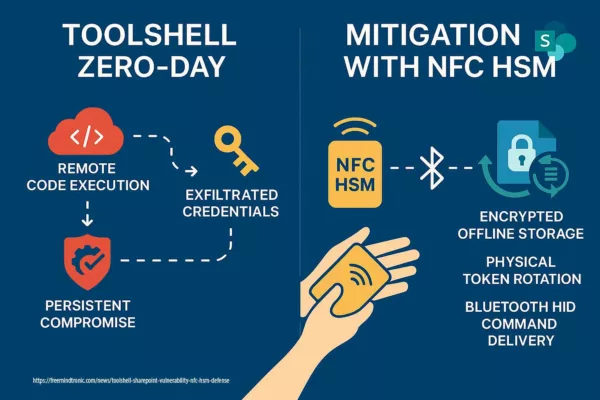

⎔ Contre-mesure souveraine

Seules des solutions souveraines comme l’isolation Zero-DOM, les HSM NFC/PGP et des gestionnaires de secrets hors ligne (DataShielder, PassCypher) permettent d’anticiper un effondrement du chiffrement classique en évitant l’exposition des clés dans l’environnement navigateur.

Paramètres de lecture

Temps de lecture résumé express : ≈ 4 minutes

Temps de lecture résumé avancé : ≈ 6 minutes

Temps de lecture complet : ≈ 36 minutes

Date de mise à jour : 2025-10-02

Niveau de complexité : Avancé / Expert

Densité technique : ≈ 73 %

Langues : CAT · EN · ES · FR

Spécificité linguistique : Lexique souverain — densité technique élevée

Accessibilité : Optimisé lecteurs d’écran — ancres sémantiques incluses

Type éditorial : Chronique stratégique — Digital Security · Quantum Computing · Cyberculture

À propos de l’auteur : Jacques Gascuel, inventeur et fondateur de Freemindtronic®, expert en cybersécurité embarquée et en cryptographie post-quantique. Pionnier de solutions souveraines basées sur le NFC, le Zero-DOM et le chiffrement matériel, ses travaux portent sur la résilience des systèmes face aux menaces du calcul quantique et sur l’authentification multifacteur sans dépendance cloud.

TL;DR —

- Percée historique : ordinateur quantique 6 100 qubits

- Menace cryptographique : RSA et ECC fragilisés

- Algorithmes de Shor & Grover rapprochés de l’usage réel

- Contre-mesure : isolation Zero-DOM, HSM NFC/PGP

Résumé avancé — Ordinateur quantique 6100 qubits

⮞ Note de lecture

Ce résumé avancé se lit en ≈ 6 minutes et prolonge le résumé express avec contexte historique, menaces cryptographiques et leviers souverains.

Point d’inflexion : franchir le seuil des 500 qubits

Changement majeur : Pour la première fois, une annonce dépasse le seuil symbolique des 1 000 qubits pour atteindre directement 6 100.

Pourquoi systémique : les infrastructures cryptographiques (RSA/ECC) reposaient sur l’hypothèse que de tels seuils ne seraient pas atteints avant plusieurs décennies.

| Vecteur | Portée | Mitigation |

|---|---|---|

| Algorithme de Shor | Brise RSA/ECC | Adopter la cryptographie post-quantique (PQC) |

| Algorithme de Grover | Divise par deux la sécurité symétrique | Doubler les longueurs de clés AES |

| Recuit quantique | Optimisation & accélération IA | Isoler les modèles souverains |

Merci d’avoir lu les résumés. La chronique complète couvrira :

- La course historique : IBM, Google, Microsoft, Atos, IonQ, atomes neutres

- Scénarios d’attaque : RSA brisé, ECC effondré, symétriques dégradés

- Compétition géopolitique et souveraineté

- Contre-mesures souveraines : Zero-DOM, HSM NFC/PGP, DataShielder

En cybersécurité souveraine ↑ Cette chronique relève de la rubrique Digital Security pour ses contre-mesures zero-trust, et de Technical News pour son apport scientifique : architectures segmentées, AES-256 CBC, mémoire volatile et auto-destruction des clés.

- 🔝 Haut rapide

- Résumé express

- Résumé avancé

- Équipe de recherche

- Ordinateur quantique 6100 qubits

- Architecture & technologie

- La course historique

- Capacités quantiques par pays

- Menaces sur le chiffrement RSA, AES, ECC, PQC

- Vecteurs d’attaque quantique

- Contre-mesures souveraines

- Cas d’usage — DataShielder & PassCypher

- Signaux faibles — géopolitique quantique

- Perspectives stratégiques

- Ce que nous n’avons pas couvert

- Glossaire

- FAQ

Points clés — Ordinateur quantique 6100 qubits

- Un saut d’échelle inédit : avec 6 100 qubits, l’ordinateur quantique franchit un seuil technologique qui remet en cause les prévisions classiques.

- Menace cryptographique directe : RSA et ECC deviennent vulnérables, obligeant à anticiper la cryptographie post-quantique.

- Algorithmes de Shor et Grover : plus proches d’une exploitation réelle, ils transforment le calcul quantique en arme stratégique.

- Réponse souveraine : l’isolation Zero-DOM, les HSM NFC/PGP et des solutions comme DataShielder ou PassCypher renforcent la résilience numérique.

- Course géopolitique accélérée : États et entreprises se disputent la suprématie quantique, avec des enjeux de souveraineté et de cybersécurité mondiale.

Ces enseignements permettent d’introduire la Chronique, où l’analyse s’étend de l’histoire du calcul quantique jusqu’aux implications concrètes pour la souveraineté numérique.

Ainsi, après ces premiers repères stratégiques, nous pouvons entrer dans le cœur de la chronique.

Équipe de recherche & trajectoire vers 6 100 qubits

Afin de mesurer précisément la portée du record, il est utile d’identifier l’équipe pionnière et les jalons techniques qui l’ont rendue possible. Le projet est conduit au Caltech (groupe Endres Lab) et décrit par Manetsch, Nomura, Bataille, Leung, Lv et Endres.

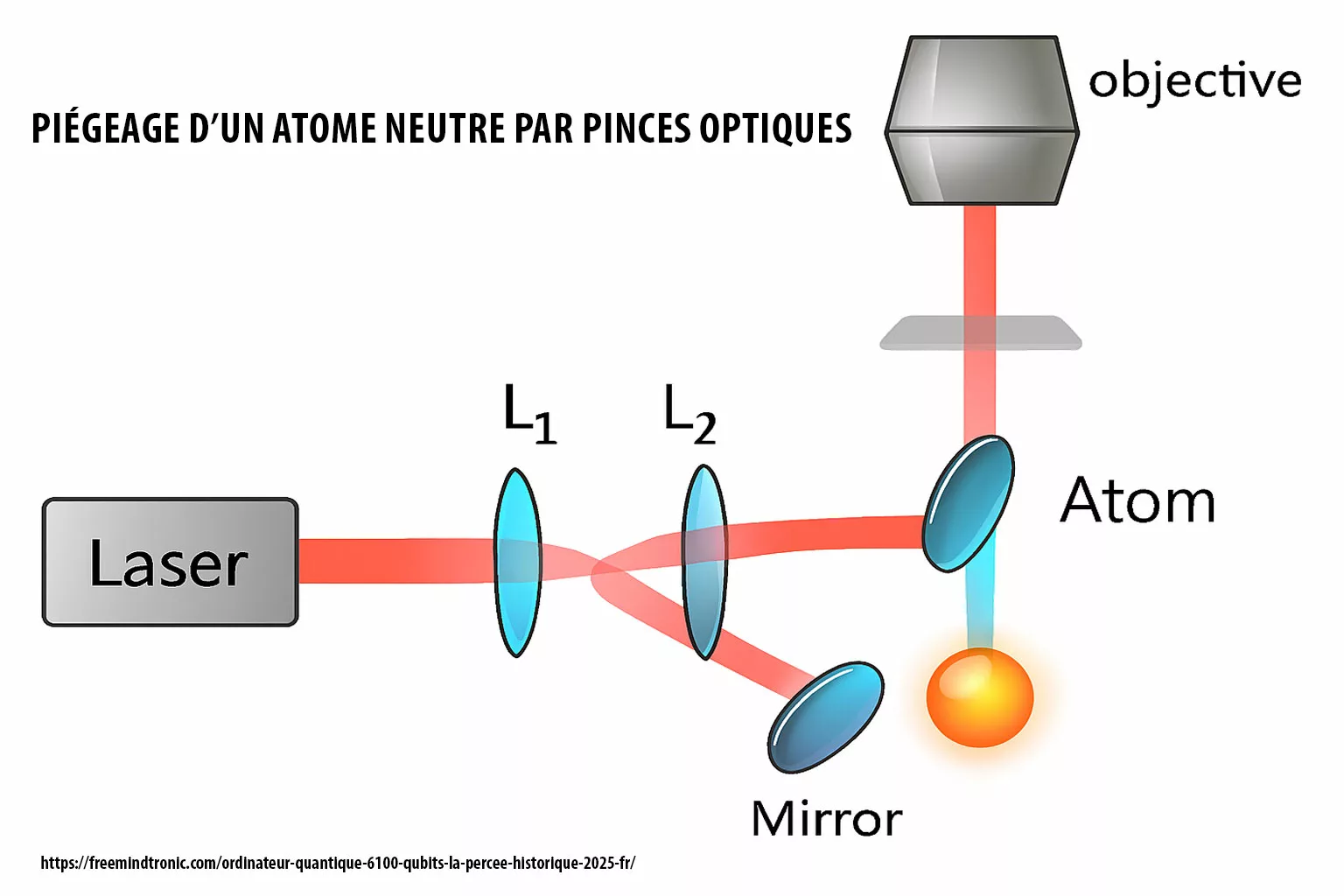

Leur architecture s’appuie sur des matrices d’atomes neutres confinés par pinces optiques (optical tweezers), une piste aujourd’hui considérée comme l’une des plus scalables vers des systèmes tolérants aux fautes.

Composition & affiliation

- Hannah J. Manetsch — Physicienne expérimentale principale en physique des atomes neutres. A conçu et mis en œuvre le protocole de piégeage à grande échelle des atomes de césium, assurant leur stabilité sur 12 000 sites. Première autrice de la publication dans Nature.

- Gyohei Nomura — Spécialiste des instruments de pinces optiques et des systèmes de contrôle. A développé la configuration du réseau laser et la logique de réadressage dynamique pour le placement et le transport des atomes.

- Élie Bataille — Expert en caractérisation de la cohérence et en métrologie quantique. A dirigé la mesure de la durée de vie des qubits hyperfins (~12,6 s) et validé leur stabilité sur de longues périodes en conditions opérationnelles.

- Kon H. Leung — Architecte du modèle informatique zoné. A élaboré les protocoles de benchmarking et les simulations de correction d’erreurs pour des opérations quantiques évolutives sur des régions modulaires.

- Xudong Lv — Spécialiste en imagerie et dynamique atomique. A conçu des systèmes d’imagerie haute fidélité (>99,99 %) et analysé la mobilité des atomes lors des opérations de prise et de dépôt, avec benchmarking aléatoire.

- Manuel Endres — Chercheur principal et directeur du laboratoire Endres à Caltech. A dirigé la stratégie de recherche globale, obtenu les financements, et coordonné l’intégration des avancées expérimentales et théoriques vers l’informatique quantique tolérante aux fautes.

Étapes techniques majeures

|

|

- Nature

- arXiv (version étendue, figures & méthodes)

- News Caltech

Pour le contexte technologique des atomes neutres : - Quanta Magazine

Ordinateur quantique 6100 qubits : découverte & contexte

Après avoir présenté les points clés de cette avancée, il est nécessaire d’examiner plus en détail la découverte elle-même.

L’annonce d’un ordinateur quantique 6100 qubits ne se limite pas à un chiffre spectaculaire : elle s’inscrit dans une trajectoire historique, technique et stratégique qui mérite d’être contextualisée.

Cette section explore le contexte scientifique, industriel et géopolitique qui a rendu possible une telle annonce.

Une percée au-delà des prototypes classiques

Jusqu’en 2024, les prototypes les plus avancés plafonnaient autour de 400 à 500 qubits.

IBM, Google, IonQ et Atos avaient démontré des architectures prometteuses, mais limitées par les contraintes de cohérence et de correction d’erreurs.

Le passage à 6 100 qubits change radicalement la perception du possible, en donnant le sentiment que les barrières prévues pour les décennies à venir pourraient être franchies en quelques années seulement.

Cette percée, présentée comme un jalon historique, reste cependant à valider par des résultats reproductibles et transparents.

Un contexte de course technologique mondiale

Il est essentiel de rappeler que cette annonce ne survient pas en vase clos.

Depuis plus de vingt ans, une compétition intense oppose les grandes puissances technologiques autour du calcul quantique.

Les États-Unis, la Chine et l’Union européenne financent massivement la recherche, tandis que des entreprises comme IBM, Google, Microsoft ou IonQ rivalisent pour revendiquer la suprématie quantique.

Derrière la performance technique, chaque bond en avant s’accompagne d’une dimension géopolitique et économique.

L’ordinateur quantique 6100 qubits s’inscrit donc dans cette logique de rivalité et d’affirmation stratégique.

Des annonces à manier avec prudence

Bien que spectaculaire, une telle annonce doit être accueillie avec circonspection.

L’expérience a montré que les chiffres bruts de qubits ne suffisent pas à garantir un usage effectif : la stabilité des qubits, leur taux d’erreur, la correction en temps réel et la scalabilité de l’architecture sont autant de paramètres décisifs.

En d’autres termes, la véritable percée n’est pas seulement dans le nombre, mais dans la capacité à rendre ces qubits utilisables et fiables.

Ce point sera déterminant pour évaluer si l’on fait face à une révolution opérationnelle ou simplement à une démonstration conceptuelle.

Après ce cadrage, il est logique de revenir sur l’historique de la course quantique.

Cela permettra de comprendre comment nous sommes passés des premiers prototypes de 2001 à cette annonce de 2025.

Architecture & technologie de l’ordinateur quantique 6100 qubits

La percée des 6 100 qubits ne repose pas sur une simple multiplication de processeurs, mais sur une technologie quantique spécifique : les atomes neutres piégés par pinces optiques (optical tweezers).

Ce choix marque une différence notable par rapport aux approches classiques comme les supraconducteurs (IBM, Google) ou les ions piégés (IonQ).

Cette architecture assure une cohérence longue (≈12,6 s), une imagerie à très haute fidélité (>99,99 %) et un design évolutif dit « zone-based », destiné à préparer la correction d’erreurs à grande échelle.

Pourquoi les atomes neutres ?

Les atomes neutres présentent plusieurs avantages stratégiques :

- Scalabilité — il est possible d’ajouter des milliers d’atomes sans perte majeure de contrôle.

- Mobilité cohérente — les qubits peuvent être déplacés (pick-up / drop-off) sur plusieurs centaines de microns avec une fidélité ~99,95 %.

- Cohérence longue — durée de vie de superposition de plusieurs secondes, supérieure aux qubits supraconducteurs.

- Architecture zone-based — segmentation en zones pour la préparation, le calcul et la correction d’erreurs.

Comparaison avec les autres technologies

- Supraconducteurs (IBM, Google) — rapides mais sensibles aux erreurs et nécessitant une cryogénie extrême.

- Ions piégés (IonQ) — excellente fidélité mais difficulté à passer à grande échelle (100+ qubits).

- Recuit quantique (D-Wave) — adapté à l’optimisation mais non universel.

- Atomes neutres (Caltech) — compromis idéal entre scalabilité, cohérence et universalité potentielle.

Sources scientifiques et institutionnelles

- Nature (2025) — publication officielle

- arXiv (2024) — version technique étendue

- Communiqué Caltech

- Quanta Magazine — neutral atoms overview

Ainsi, la technologie des atomes neutres devient une piste crédible vers le quantique tolérant aux fautes,

et l’annonce des 6 100 qubits doit être comprise comme un jalon technique décisif, autant qu’un signal géopolitique.

La course historique vers l’ordinateur quantique 6100 qubits

Pour comprendre la portée de l’annonce des 6 100 qubits, il est indispensable de replacer cette avancée dans une trajectoire historique.

Depuis le début des années 2000, plusieurs acteurs ont contribué à jalonner la progression vers la suprématie quantique.

Chaque étape a construit les bases techniques et stratégiques qui rendent crédible une telle percée.

Leurs prototypes successifs montrent comment le secteur est passé de quelques qubits instables à des milliers annoncés.

IBM : pionnier et continuité

Dès 2001, IBM réalisait la première exécution d’un algorithme de Shor sur un ordinateur quantique rudimentaire à 7 qubits.

Au fil des années, IBM a proposé une feuille de route claire, visant 1 000 qubits en 2023 avec le processeur « Condor ».

Leur stratégie a consisté à offrir un accès à distance via le cloud quantique, préparant une base d’utilisateurs académiques et industriels.

L’annonce d’un ordinateur quantique 6100 qubits s’inscrit donc dans le prolongement de cette vision.

Google : la revendication de la suprématie

En 2019, Google affirmait avoir atteint la « suprématie quantique » avec Sycamore, un processeur de 53 qubits capable de réaliser en 200 secondes un calcul que les superordinateurs classiques mettraient des millénaires à simuler.

Bien que critiquée pour ses conditions expérimentales, cette annonce a marqué un tournant médiatique et stratégique.

Elle a accentué la rivalité technologique avec IBM et ouvert la voie à des projets plus ambitieux.

Microsoft : l’approche des qubits topologiques

Moins médiatisé mais tout aussi ambitieux, Microsoft a misé sur les qubits topologiques, réputés plus stables et moins sujets aux erreurs.

Bien que cette approche ait pris du retard par rapport aux architectures supraconductrices, elle illustre la diversité des voies explorées.

Microsoft a également investi massivement dans l’écosystème logiciel (Q#, Azure Quantum), préparant l’arrivée d’applications hybrides.

Atos : la stratégie européenne

En Europe, Atos a adopté une posture singulière avec son simulateur quantique QLM (Quantum Learning Machine), destiné à former des chercheurs et à tester des algorithmes avant leur déploiement réel.

Cette approche pragmatique a permis de réduire le fossé entre recherche et industrie, même si elle reste éloignée des annonces spectaculaires de milliers de qubits.

IonQ : l’alternative des ions piégés

Fondée en 2015, IonQ a misé sur la technologie des ions piégés, considérée comme plus modulable.

Leur architecture a atteint une centaine de qubits stables et a convaincu de grands investisseurs comme Amazon et Google Cloud.

L’annonce des 6 100 qubits représente pour IonQ à la fois un défi et une opportunité : prouver la viabilité de leur modèle face à des géants mieux établis.

D-Wave : le pionnier du recuit quantique

Enfin, D-Wave s’est distingué par son approche du recuit quantique, axée sur l’optimisation plutôt que sur l’exécution d’algorithmes universels.

Avec des systèmes dépassant déjà les 5 000 qubits en 2020, D-Wave a montré qu’il était possible de manipuler des échelles importantes.

Cependant, la nature spécialisée de ses machines les rend moins comparables aux architectures universelles visées par IBM ou Google.

En retraçant ces jalons, on constate que l’ordinateur quantique 6100 qubits s’inscrit dans une course cumulative.

Il est donc naturel d’examiner maintenant les menaces que cette avancée fait peser sur le chiffrement, cœur de la cybersécurité mondiale.

Capacités quantiques mondiales : architectures souveraines et portée stratégique (2025)

Vue stratégique

Cette section cartographie le paysage mondial de l’informatique quantique, en mettant en lumière l’architecture dominante, la capacité en qubits et la posture stratégique de chaque pays. Elle permet de comparer les capacités souveraines et d’anticiper les échéances de rupture cryptographique.

Tableau comparatif

| Pays | Institution / Programme | Architecture | Qubits (2025) | Notes stratégiques |

|---|---|---|---|---|

| 🇺🇸 États-Unis | Caltech, IBM, Google, Microsoft, IonQ | Atomes neutres, supraconducteurs, topologiques, ions piégés | 6 100 (Caltech), 1 121 (IBM), 100+ (Google) | Scalabilité zonale, prototype Majorana, benchmarks de suprématie |

| 🇫🇷 France | Atos / Eviden | HPC hybride, émulation | ~50 simulés | Intégration QLM, convergence souveraine HPC–quantique |

| 🇨🇳 Chine | USTC / Zuchongzhi | Supraconducteurs | ~105 qubits | Vitesse annoncée 1M× supérieure à Sycamore, feuille de route nationale |

| 🇷🇺 Russie | Russian Quantum Center | Hybride supraconducteurs / ions | ~50 qubits | Priorité aux communications sécurisées, souveraineté nationale |

| 🇰🇷 Corée du Sud | Quantum Korea | Supraconducteurs + photonique | ~30 qubits | Accent sur le photonique, stratégie nationale de R&D |

| 🇯🇵 Japon | RIKEN / NTT / Fujitsu | Supraconducteurs / photonique | ~64 qubits | Systèmes hybrides : recuit quantique + portes logiques |

| 🇨🇦 Canada | D-Wave Systems | Recuit quantique | >5 000 qubits | Optimisation ciblée, non universel en portes logiques |

| 🇩🇪 Allemagne | Fraunhofer / IQM | Supraconducteurs / ions | ~30 qubits | Financement européen, intégration industrielle |

| 🇬🇧 Royaume-Uni | Oxford Quantum Circuits | Supraconducteurs / photonique | ~32 qubits | Systèmes modulaires accessibles via le cloud |

| 🇮🇳 Inde | MeitY / IISc | Supraconducteurs (phase initiale) | <20 qubits | Lancement d’une mission nationale, premiers prototypes |

| 🇮🇱 Israël | Quantum Machines / Bar-Ilan | Systèmes de contrôle / hybride | Focalisation sur la couche de contrôle | Spécialisation en orchestration et intégration quantique-classique |

Menaces sur le chiffrement face à l’ordinateur quantique 6100 qubits

Après avoir retracé la course historique qui a conduit à l’annonce d’un ordinateur quantique 6100 qubits, il convient d’analyser l’impact direct de cette avancée sur les systèmes de chiffrement.

Car au-delà des prouesses techniques, c’est bien la sécurité des communications numériques mondiales qui est en jeu.

RSA et ECC pourraient être brisés, AES fragilisé, et la cryptographie post-quantique (PQC) devient une nécessité urgente.

RSA : une forteresse vulnérable

Le chiffrement RSA, basé sur la factorisation de grands nombres premiers, a longtemps été considéré comme inattaquable par les ordinateurs classiques.

Or, l’algorithme de Shor, exécuté sur un nombre suffisant de qubits stables, rend théoriquement possible la factorisation en temps polynomial.

Avec 6 100 qubits, la perspective d’un RSA compromis passe d’hypothèse lointaine à menace crédible.

Cette fragilité expose directement les certificats SSL/TLS et les infrastructures PKI.

Le risque sur RSA et ECC découle de l’algorithme de Shor, qui démontre la factorisation et le logarithme discret en temps polynomial sur ordinateur quantique : article SIAM (1997) et prépublication arXiv.

ECC : l’effondrement de l’elliptique

Les courbes elliptiques (ECC) ont été adoptées comme alternative plus légère à RSA, notamment pour les objets connectés et les systèmes embarqués.

Cependant, elles reposent sur le problème du logarithme discret, tout aussi vulnérable à l’algorithme de Shor.

Ainsi, un ordinateur quantique 6100 qubits rendrait ECC caduc, menaçant l’authentification et la signature numérique dans de nombreux environnements contraints.

AES : une robustesse relative

À l’inverse de RSA et ECC, le chiffrement symétrique AES résiste mieux.

Toutefois, l’algorithme de Grover permet de réduire la complexité d’attaque de 2^n à 2^(n/2).

Concrètement, une clé AES-128 offrirait une sécurité équivalente à une clé classique de 64 bits face à un attaquant quantique.

Cela impose de passer à AES-256 pour conserver un niveau de sécurité adéquat.

Pour le chiffrement symétrique, l’algorithme de Grover réduit quadratiquement l’espace de recherche (≈ 2n/2) :

papier arXiv (1996) et PDF. D’où la recommandation d’opter pour AES-256 dans les environnements sensibles.

PQC : la transition impérative

Face à ces menaces, la cryptographie post-quantique (PQC) émerge comme la seule réponse durable.

Le NIST a déjà lancé la standardisation de nouveaux algorithmes résistants aux attaques quantiques, tels que CRYSTALS-Kyber (chiffrement) et Dilithium (signature).

Cependant, la migration mondiale vers ces normes est encore lente.

L’annonce d’un ordinateur quantique 6 100 qubits agit donc comme un accélérateur brutal, imposant une transition immédiate.

Dès lors, il devient nécessaire d’examiner les vecteurs d’attaque et les scénarios de cryptanalyse qui exploiteraient concrètement cette puissance de calcul quantique.

La PQC est désormais normalisée : FIPS 203/204/205 publiés le 13 août 2024 (ML-KEM ex-Kyber, ML-DSA ex-Dilithium, SPHINCS+) :

communiqué NIST et page projet CSRC. La page de standardisation PQC suit l’état des textes et profils.

Vecteurs d’attaque quantique face à l’ordinateur quantique 6100 qubits

À présent que nous avons exposé les menaces structurelles pesant sur les systèmes de chiffrement classique, il est nécessaire d’examiner les mécanismes précis que pourrait exploiter un ordinateur quantique 6100 qubits.

Cette section détaille les algorithmes quantiques fondamentaux — principalement Shor et Grover — ainsi que les stratégies hybrides telles que le “Harvest Now, Decrypt Later”.

Un adversaire pourra aussi accumuler des données chiffrées aujourd’hui pour les déchiffrer plus tard avec une machine quantique suffisamment puissante.

Algorithme de Shor : la rupture asymétrique

L’algorithme de Peter Shor (1994) est la pierre angulaire de l’attaque quantique contre les systèmes asymétriques. Il permet de factoriser des entiers en temps polynômial et de calculer des logarithmes discrets, fonctions centrales de RSA et ECC.

Pour des clés RSA de haute taille (ex. 2048 bits), les estimations montrent que plusieurs millions de qubits stables seraient nécessaires.

Quelques démonstrations expérimentales à très faible échelle ont déjà été réalisées (ex. factorisation de 15) en utilisant des architectures quantiques (ion traps) avec recyclage de qubits.

Mais la vraie rupture viendra le jour où un appareil pourra exécuter Shor sur des tailles de clés appliquées (RSA-2048 ou ECC-curve) avec fiabilité et faible taux d’erreur.

Algorithme de Grover : accélération des recherches symétriques

L’algorithme de Grover, publié en 1996, offre un moyen quantique quadratique d’accélérer les recherches non structurées.

Concrètement, Grover permet de réduire la complexité d’attaque d’une clé AES de longueur ( n ) de ( 2^n ) à environ ( 2^{n/2} ).

Ainsi, une clé AES-128 devient équivalente, en résistance quantique, à une clé de 64 bits, ce qui est manifestement insuffisant.

Même AES-256 n’est pas immunisé : la sécurité effective est réduite à une portée de ~128 bits, ce qui reste robuste mais impose prudence.

Des études récentes examinent la mise en œuvre pratique de Grover dans des circuits quantiques profonds et limités par le “depth constraint” imposé par les standards PQC du NIST.

Harvest Now, Decrypt Later (stockage adaptatif)

Un adversaire peut adopter une stratégie dite “harvest now, decrypt later”. iI intercepte aujourd’hui des communications chiffrées et les stocke, dans l’espoir de les déchiffrer plus tard, une fois que le calcul quantique aura atteint sa maturité. Autrement dit, cette approche ne repose pas sur une puissance immédiate, mais sur une projection stratégique à long terme, fondée sur l’évolution prévisible des capacités de calcul. En conséquence, les protocoles à longue durée de vie — archives, messages confidentiels, clés privées — deviennent vulnérables bien avant l’émergence d’un système à 6 100 qubits pleinement opérationnel, rendant la migration vers des schémas post-quantiques d’autant plus urgente.

Après avoir identifié les principaux vecteurs d’attaque (algorithmes de Shor et Grover, stockage adaptatif), il devient impératif d’explorer les contre-mesures souveraines : Zero-DOM, HSM NFC/PGP, segmentation de clés, exécution hors OS, et mémoire volatile avec auto-destruction. Ces dispositifs constituent le socle d’une défense proactive, capable de protéger les infrastructures sensibles contre les ruptures cryptographiques à venir.

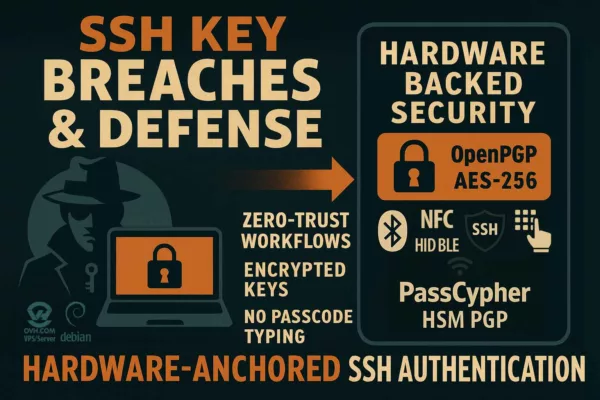

Contre-mesures souveraines face à l’ordinateur quantique 6100 qubits

À ce stade, et parce que la menace se précise, il convient d’établir une doctrine opérationnelle.

Pour réduire immédiatement la surface d’attaque — même en présence d’un ordinateur quantique 6100 qubits — la stratégie souveraine repose sur trois axes complémentaires :

confinement d’exécution hors OS, ancrage matériel HSM NFC/PGP et gouvernance crypto-agile (PQC).

1) Confinement d’exécution souverain : supprimer l’environnement interprétable

L’architecture repose sur un périmètre d’exécution souverain, hors navigateur et hors OS, garantissant que les opérations cryptographiques ne transitent jamais par un environnement interprétable.

Cela neutralise les attaques par détournement d’interface, XSS, keylogging web, vol de jetons, fingerprinting ou dérivation locale.

Les opérations sensibles (signature, chiffrement, dérivation) sont exécutées dans un espace minimal, non interprétable, et inviolable.

2) Ancrage matériel : HSM NFC/PGP à clé segmentée

Les HSM NFC/PGP assurent que les clés privées ne quittent jamais le matériel.

Deux modes de mise en œuvre sont distingués :

- Dispositif NFC HSM : permet à l’utilisateur d’ajouter librement plus de 9 segments de clés cumulatives, chacune caractérisée par un critère de confiance. Cette approche offre une granularité renforcée dans la gestion des secrets et une résilience accrue face aux ruptures asymétriques.

- Extension navigateur HSM PGP : repose sur une paire de segments symétriques autonomes de 256 bits chacun (soit 512 bits au total), stockés séparément. Ces segments sont inutilisables en l’état sans l’algorithme de concaténation souverain qui reconstitue dynamiquement une clé AES-256 CBC sécurisée.

Ce principe est protégé par le brevet international WO2018154258 — Système d’authentification à clé segmentée.

3) Crypto-agilité : PQC, profils hybrides et rotation

La transition vers la cryptographie post-quantique impose :

– le déploiement de profils hybrides (classique + PQC),

– la rotation des certificats et des clés critiques,

– le renforcement symétrique (ex. AES-256),

– et l’intégration anticipée des schémas PQC standardisés (ML-KEM, ML-DSA, SPHINCS+).

4) Architecture de déploiement : du poste au terrain

- Postes & serveurs : exécution hors OS pour les opérations de clé ; HSM pour signature & déchiffrement.

- Mobilité : usage NFC pour activer la clé à la demande, sans exposition persistante.

- OT / environnements contraints : profils offline-first, absence de dépendance cloud, journaux inviolables.

5) Plan d’action 90 jours (priorités)

- Inventorier les données à longue durée de vie (archives, secrets stratégiques) et cartographier PKI & usages RSA/ECC.

- Isoler toutes les opérations de clé dans un périmètre d’exécution souverain et basculer les secrets maîtres sur HSM NFC/PGP à clé segmentée.

- Durcir le chiffrement symétrique (AES-256) et activer des profils hybrides vers la PQC.

- Roter certificats et secrets critiques ; documenter la preuve de non-exposition (audits, journaux).

Ainsi outillée, l’organisation évite l’effet de falaise en cas de rupture cryptographique.

Pour illustrer concrètement cette doctrine, passons maintenant au cas d’usage — DataShielder & PassCypher, qui démontrent comment l’exécution souveraine et l’ancrage matériel se combinent, en pratique, pour neutraliser les vecteurs d’exfiltration et réduire le risque systémique.

Cas d’usage — DataShielder & PassCypher face à l’ordinateur quantique 6100 qubits

Après avoir présenté les principes des contre-mesures souveraines, il est essentiel d’illustrer leur application concrète.

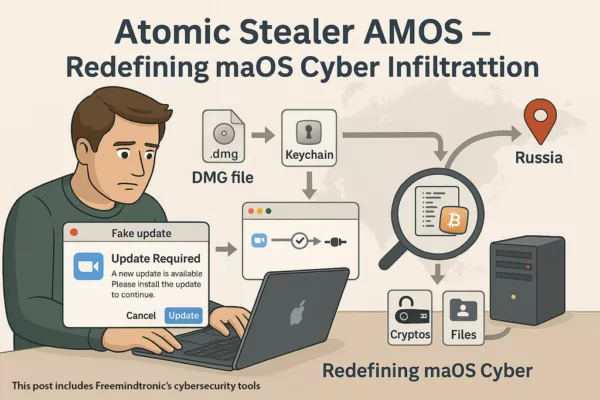

Deux solutions développées par Freemindtronic, DataShielder et PassCypher, démontrent comment anticiper dès aujourd’hui les menaces liées à un ordinateur quantique 6100 qubits.

DataShielder : sécuriser les communications sensibles

DataShielder repose sur un HSM hybride matériel/logiciel, décliné en deux versions :

- Version NFC HSM : la clé AES-256 est stockée dans un support physique NFC, utilisée via une application mobile NFC. Elle est chargée en mémoire volatile le temps de l’usage, puis auto-détruite. Aucune trace persistante n’est laissée dans l’environnement hôte.

- Version navigateur HSM PGP : repose sur une paire de segments symétriques autonomes de 256 bits chacun :

- Le premier segment est stocké dans le local storage du navigateur,

- Le second segment est conservé dans un support physique NFC.

Ces segments sont inutilisables en l’état.

L’extension navigateur doit être informée de l’emplacement exact des deux segments pour déclencher l’algorithme de concaténation souverain, qui reconstitue dynamiquement une clé AES-256 CBC utilisable.

Cette clé est chargée en mémoire volatile le temps de l’opération, puis auto-détruite immédiatement après usage.

Ce mécanisme garantit que la clé complète n’existe jamais en mémoire persistante, ni dans le navigateur, ni dans l’OS.

PassCypher : gestionnaire de secrets souverain

PassCypher propose également ces deux mises en œuvre :

- Version NFC HSM : permet à l’utilisateur d’ajouter librement plus de 9 segments de clés cumulatives, chacune associée à un critère de confiance. La reconstitution de la clé AES-256 est conditionnée à la présence simultanée des segments, assurant un cloisonnement matériel total.

- Version navigateur HSM PGP : identique à celle de DataShielder, avec une paire de segments autonomes de 256 bits, concaténés dynamiquement pour générer une clé AES-256 CBC temporaire, chargée en mémoire volatile puis auto-détruite après usage.

Ces mécanismes sont protégés par deux brevets internationaux complémentaires :

– 📄 WO2018154258 – Système d’authentification à clé segmentée

– 📄 WO2017129887 – Système de sécurité électronique embarqué

Ensemble, ils garantissent une protection souveraine des secrets, hors cloud, hors OS, et résiliente face aux ruptures cryptographiques post-quantiques.

Une anticipation des menaces quantiques

En combinant ces deux approches, Freemindtronic illustre une stratégie claire et immédiatement opérationnelle : d’une part, isoler physiquement les secrets pour empêcher toute exfiltration, d’autre part, éviter leur exposition logicielle en supprimant les environnements interprétables, tout en garantissant une résilience immédiate face aux menaces futures.

Dans ce contexte de basculement technologique, où la perspective d’un ordinateur quantique à 6100 qubits accélère l’urgence de la migration vers la cryptographie post-quantique, ces solutions apparaissent comme des garde-fous stratégiques — à la fois souverains, modulaires et auditables.

Ce chiffre dépasse l’âge estimé de l’univers, illustrant la robustesse des secrets stockés dans les dispositifs EviTag NFC HSM ou EviCard NFC HSM.

Cette démonstration est détaillée dans la chronique 766 trillion years to find a 20-character password, et renforce la doctrine de segmentation, de mémoire volatile et d’auto-destruction des clés.

Après avoir exploré ces cas d’usage, il est important de s’intéresser aux signaux faibles qui entourent la course au quantique.

Ils révèlent des enjeux moins visibles, mais tout aussi décisifs, liés à la géopolitique, à la normalisation et à l’espionnage industriel.

Signaux faibles — géopolitique et risques périphériques autour de l’ordinateur quantique 6100 qubits

Après l’analyse technique et les cas d’usage souverains, il est utile, et même indispensable, d’identifier les signaux faibles qui rendent le contexte plus incertain.

En effet, ces indices discrets mais récurrents permettent d’anticiper des ruptures stratégiques.

Ainsi, plutôt que d’attendre la certitude, il faut considérer plusieurs tendances émergentes simultanément.

Intensification des financements publics et privés

D’une part, les États multiplient les programmes de soutien et les fonds dédiés au quantique ; d’autre part, les grands groupes privés accélèrent leurs R&D.

Par conséquent, l’effort cumulé réduit le délai entre recherche et démonstration industrielle.

De plus, cette dynamique crée des dépendances technologiques et des risques de concentration industrielle.

Brevets, publication scientifique et fuite d’informations

Les dépôts de brevets se multiplient, tandis que certaines publications techniques, parfois prématurées, laissent filtrer des informations sensibles.

En outre, les cas d’espionnage industriel ciblant la propriété intellectuelle quantique deviennent plus fréquents.

Ainsi, il est probable que des avancées annoncées publient des capacités partielles, volontairement incomplètes, lesquelles exigent néanmoins une vigilance renforcée.

Comportements adverses : interception différée et rumeurs de transferts d’expertise

Les acteurs malveillants — qu’ils soient étatiques ou criminels — pratiquent le stockage massif de données chiffrées aujourd’hui en vue d’une décryption future.

Par ailleurs, des transferts transfrontaliers de compétences et des relations sous-traitantes augmentent la surface d’exfiltration.

Il en résulte un besoin urgent de protéger les archives sensibles et de prioriser la migration des données critiques vers des schémas résistants au quantique.

Risque systémique et chaînes d’approvisionnement

Enfin, la concentration des capacités de production (cryogénie, fabrication de circuits, métrologie) crée des points de fragilité.

Par conséquent, la souveraineté technologique devient stratégique : les États qui ne maîtrisent pas ces chaînes sont exposés à des ruptures d’approvisionnement ou à des verrouillages technologiques.

En tenant compte de ces signaux faibles, il est naturel d’envisager plusieurs scénarios prospectifs.

Ainsi, la section suivante propose un panorama prospectif — court, moyen et long terme — sur l’impact d’un ordinateur quantique 6100 qubits.

Perspectives stratégiques — scénarios autour de l’ordinateur quantique 6100 qubits

À présent, et parce que la stratégie exige la projection, nous proposons trois scénarios plausibles : consolidation contrôlée, accélération disruptive et déstabilisation systémique. Chacun d’eux articule des facteurs techniques, politiques et économiques, et reflète des trajectoires contrastées mais crédibles. En conséquence, ces scénarios doivent guider les décisions opérationnelles — patching, migration, isolation et souveraineté matérielle — à court et moyen terme, en tenant compte des signaux faibles et des interdépendances systémiques.

La probabilité relative dépendra des données d’erreur, de la reproductibilité et des mesures de mitigation déployées.

Scénario 1 — Consolidation contrôlée

Dans ce scénario, l’annonce de 6 100 qubits se révèle partiellement prématurée : après vérification, la machine nécessite encore des améliorations de fiabilité. En conséquence, la transition vers le quantique utile reste graduelle, marquée par des phases d’ajustement technologique. Pour autant, cette trajectoire impose d’accélérer la standardisation PQC, de prioriser l’inventaire des actifs à protéger, et de renforcer les HSM nationaux afin de garantir une résilience anticipée.

Scénario 2 — Accélération disruptive

Ici, la machine devient rapidement opérante pour certaines classes d’algorithmes : la pression sur les systèmes cryptographiques augmente, et la course au déploiement des contre-mesures s’intensifie. Dans ce contexte, les organisations devront mettre en œuvre des migrations hybrides (classique + PQC) et adopter des solutions souveraines hors ligne pour les clés sensibles. Parallèlement, l’industrie devra accélérer la production d’HSM et de composants souverains, afin de répondre à la demande croissante en infrastructures résilientes.

Scénario 3 — Déstabilisation systémique

Dans le pire des cas, des adversaires exploitent des capacités quantiques suffisantes pour compromettre des segments critiques (PKI, signatures, archives), provoquant une rupture de confiance généralisée. Face à une telle éventualité, des réponses extraordinaires seront nécessaires : révocation massive, réforme des infrastructures PKI, et renforcement international de la coopération en matière d’alertes et de standards.

Dès lors, quelles que soient les probabilités, la recommandation stratégique est claire : préparer des réponses souveraines immédiates (HSM, Zero-DOM, PassCypher), accélérer la mise en œuvre de la PQC et inventorier les données à long terme susceptibles d’être cibles d’un « harvest now, decrypt later ».

Ce que nous n’avons pas couvert

- Coût industriel — fabrication, cryogénie et montée en production des composants quantiques (non couverts ici).

- Empreinte énergétique — consommation et contraintes physiques des grands dispositifs quantiques.

- Aspects juridiques et normatifs — régulation, responsabilité et contrôle des exportations technologiques.

- Stack logiciel détaillé — compilateurs quantiques, couches d’abstraction et middleware spécifiques.

Ces sujets feront l’objet de publications ultérieures.

En attendant, nous recommandons aux responsables de sécurité d’entreprise et aux décideurs publics de lancer des audits d’archives à haut risque et d’élaborer des feuilles de route PQC adaptées à leurs domaines d’activité.

Glossaire — termes clés

- Qubit — unité d’information quantique ; analogue quantique du bit, susceptible d’être en superposition.

- Cohérence — durée pendant laquelle un qubit conserve ses propriétés quantiques utiles.

- Correction d’erreurs quantiques — techniques nécessaires pour rendre des qubits fiables (codes de surface, etc.).

- Algorithme de Shor — algorithme quantique permettant la factorisation et le calcul de logarithmes discrets, menaçant RSA/ECC.

- Algorithme de Grover — algorithme quantique quadratique d’accélération des recherches non structurées, diminuant la sécurité symétrique.

- HSM (Hardware Security Module) — module matériel sécurisé pour stocker et opérer des clés cryptographiques.

- Zero-DOM — doctrine d’isolation hors navigateur empêchant l’exposition des secrets à l’environnement web.

- PQC (Post-Quantum Cryptography) — famille d’algorithmes résistants aux attaques quantiques, en cours de standardisation par le NIST.

Pour une lecture approfondie, consultez nos outils et notes techniques sur les menaces quantiques pour le chiffrement et sur la protection des mots de passe à l’ère quantique.

FAQ — Questions fréquentes sur ordinateur quantique 6100 qubits

Il est difficile de donner une date précise. Cependant, si une machine à plusieurs milliers de qubits logiques à faible taux d’erreur devient disponible, la probabilité augmente fortement. Il est donc prudent d’agir comme si le risque était imminent : migrer vers la PQC et protéger les archives sensibles.

AES-128 devient insuffisant face à Grover ; AES-256 conserve une marge de sécurité. Il est recommandé de privilégier AES-256 pour les actifs critiques et de planifier la gestion des clés sur HSM souverains.

Pas immédiatement. Il convient de prioriser la révocation et la rotation des clés pour les certificats utilisés dans des fonctions critiques : signature de code, PKI industrielle, archives réglementées.

Lister les données à long terme, inventorier les systèmes PKI, déployer des HSM souverains pour les clés maîtresses, activer des plans de migration PQC et adopter des solutions Zero-DOM pour les secrets exposés au navigateur.

Elle marque un saut d’échelle inédit. Toutefois, la stabilité des qubits, leur taux d’erreur et la reproductibilité des résultats doivent être vérifiés. La prudence stratégique impose d’anticiper comme si l’annonce était opérationnelle.

RSA et ECC sont directement vulnérables via l’algorithme de Shor. AES est partiellement fragilisé par Grover. La cryptographie post-quantique devient impérative pour maintenir la résilience.

À cause de la stratégie “Harvest Now, Decrypt Later”, des adversaires stockent aujourd’hui des données chiffrées dans l’espoir de les casser plus tard, une fois les capacités quantiques disponibles. Dès lors, les archives à longue durée de vie — contrats, brevets, données biométriques, preuves judiciaires — doivent être migrées en priorité vers des schémas cryptographiques post-quantiques. En d’autres termes, la temporalité du risque impose une hiérarchisation immédiate des actifs à protéger, en fonction de leur durée de sensibilité et de leur valeur stratégique.

Isolation Zero-DOM, HSM NFC/PGP, gestionnaires de secrets hors ligne comme PassCypher et DataShielder. Ces solutions évitent l’exposition des clés dans l’environnement navigateur et renforcent la résilience face au quantique.

Non. Même si les standards PQC sont en cours de finalisation, il est stratégique de commencer la migration dès maintenant, en combinant solutions hybrides et souveraines.

Trois trajectoires :

1) consolidation scientifique graduelle ;

2) adoption commerciale accélérée ;

3) déstabilisation systémique.

Dans tous les cas, il faut préparer des réponses souveraines immédiates.

Non. Il a été démontré expérimentalement sur des cas simples (ex. factorisation de 15), mais pas encore sur des clés RSA-2048. Toutefois, l’annonce des 6100 qubits rapproche cette possibilité. Il faut donc anticiper comme si l’exploitation était imminente.

Parce qu’elles reposent sur le logarithme discret, également cassable par l’algorithme de Shor. Leur légèreté ne les protège pas du quantique. Elles sont donc à migrer en priorité dans les environnements contraints.

Non. Grover réduit la sécurité effective d’AES-128 à celle d’une clé de 64 bits. AES-256 reste robuste, mais impose une gestion rigoureuse des clés et une rotation planifiée.

C’est une tactique où des adversaires interceptent aujourd’hui des données chiffrées pour les casser plus tard avec un ordinateur quantique. Cela rend les archives sensibles vulnérables dès maintenant.

Non. Elles exposent les clés dans des environnements partagés. Seules des solutions hors ligne, comme les HSM NFC/PGP et l’isolation Zero-DOM, garantissent une résilience souveraine.

Non. La migration peut commencer dès maintenant avec des profils hybrides (classique + PQC), en intégrant les algorithmes déjà sélectionnés par le NIST comme CRYSTALS-Kyber et Dilithium.

Augmentation des brevets quantiques, fuites technologiques, espionnage industriel, transferts d’expertise transfrontaliers et concentration des chaînes d’approvisionnement. Ces signaux réduisent la fenêtre de résilience.

En comparant RSA à une serrure mécanique et l’ordinateur quantique à un passe universel. Même si ce passe n’est pas encore dans toutes les mains, il existe. Il faut donc changer les serrures avant qu’il ne devienne accessible.

Elle garantit que les clés, les algorithmes et les infrastructures ne dépendent pas d’acteurs tiers. Sans souveraineté, la résilience est illusoire. Les solutions doivent être auditées, hors cloud, et maîtrisées de bout en bout.

Perte de confidentialité des archives, compromission des signatures de code, falsification de preuves numériques, et perte de confiance dans les infrastructures critiques. L’inaction est un pari risqué sur un calendrier inconnu.

• RSA et ECC sont condamnés à moyen terme.

• AES-256 reste robuste, mais doit être bien géré.

• Les archives sont déjà vulnérables.

• La migration PQC ne peut plus attendre.

• La souveraineté est la seule garantie de résilience.